Em janeiro deste ano, o doutorando do Programa de Pós-graduação em Ciência da Computação (PPGCC) da UFMG, Flávio Coutinho, e o professor do Departamento de Ciência da Computação (DCC), Luiz Chaimowicz, publicaram na revista Graphical Models o trabalho “Pixel art character generation as an image-to-image translation problem using GANs“. No início de setembro, esse artigo foi premiado como o melhor da revista ao longo do ano de 2024. Agora, em outubro deste ano, os dois pesquisadores publicaram mais um artigo: “A Missing Data Imputation GAN for Character Sprite Generation”, desta vez no XXIII Brazilian Symposium on Digital Games and Entertainment (SBGames 2024), e este também foi premiado como melhor artigo na trilha de Computação do evento.

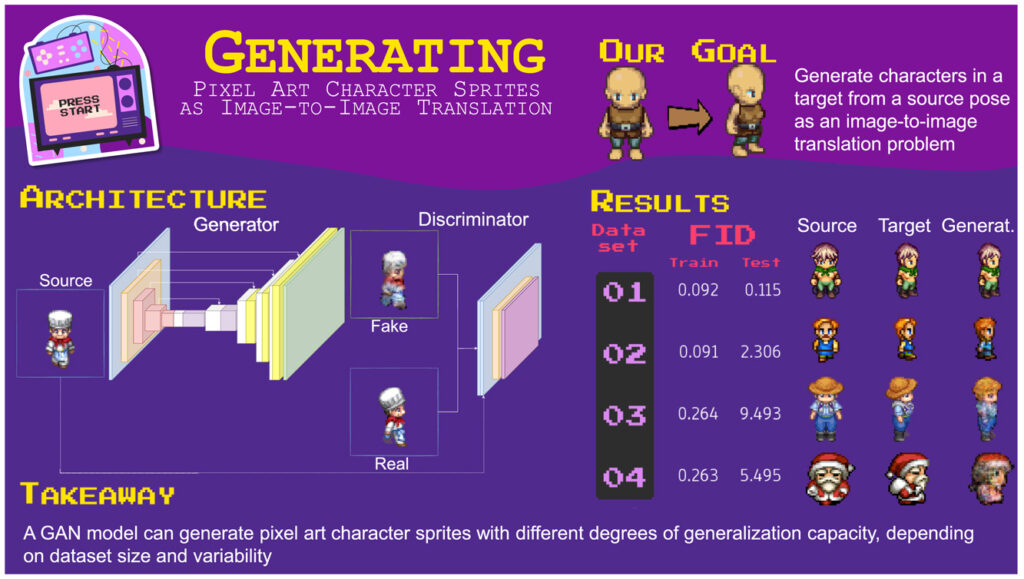

Conheça abaixo o resumo do artigos “Pixel art character generation as an image-to-image translation problem using GANs“

Abstract

Asset creation in game development usually requires multiple iterations until a final version is achieved. This iterative process becomes more significant when the content is pixel art, in which the artist carefully places each pixel. We hypothesize that the problem of generating character sprites in a target pose (e.g., facing right) given a source (e.g., facing front) can be framed as an image-to-image translation task. Then, we present an architecture of deep generative models that takes as input an image of a character in one domain (pose) and transfers it to another. We approach the problem using generative adversarial networks (GANs) and build on Pix2Pix’s architecture while leveraging some specific characteristics of the pixel art style. We evaluated the trained models using four small datasets (less than 1k) and a more extensive and diverse one (12k). The models yielded promising results, and their generalization capacity varies according to the dataset size and variability. After training models to generate images among four domains (i.e., front, right, back, left), we present an early version of a mixed-initiative sprite editor that allows users to interact with them and iterate in creating character sprites.

Resumo:

Neste trabalho nós investigamos a criação de personagens em pixel art, que é uma tarefa de geração procedural de conteúdo para jogos digitais. Encaramos esse problema como de tradução de imagem-para-imagem e propomos uma arquitetura de Redes Geradoras Adversárias (em inglês, GANs) capaz de transformar um personagem desenhado em uma pose (e.g., frente) para outra (e.g., virado para a direita). Fizemos experimentos com quatro pequenos conjuntos de personagens (menores que 1k exemplo) e também com um conjunto que contempla 14k personagens com diversos estilos de arte diferentes. Os resultados tiveram qualidade que varia de acordo com o tamanho e diversidade do conjunto de dados. Em alguns em que há pouca variação entres os personagens, o modelo treinado foi capaz de gerar perfeitamente o personagem na pose de destino. Noutros conjuntos mais difíceis, o modelo conseguiu gerar bons personagens em alguns casos, mas ruins em outros. O saldo é que a arquitetura proposta é capaz de gerar personagens com boa qualidade quanto mais próximos são os personagens desejados do conjunto de treinamento. Mas vimos que havia oportunidades para melhorar a qualidade. Por exemplo, em vez de usar apenas uma imagem do personagem como entrada para o modelo, poderíamos usar três (e.g., virado para a esquerda, de costas e de frente para gerar o personagem olhando para a direita).

Para saber mais sobre o artigo “A Missing Data Imputation GAN for Character Sprite Generation”, acesse o hotsite do artigo onde tem uma imagem ilustrativa, um vídeo apresentando e outras informações. Também há como experimentar o modelo treinado a partir do navegador em uma demonstração interativa.

Abstract:

Creating and updating pixel art character sprites with many frames spanning different animations and poses takes time and can quickly become repetitive. However, that can be partially automated to allow artists to focus on more creative tasks. In this work, we concentrate on creating pixel art character sprites in a target pose from images of them facing other three directions. We present a novel approach to character generation by framing the problem as a missing data imputation task. Our proposed generative adversarial networks model receives the images of a character in all available domains and produces the image of the missing pose. We evaluated our approach in the scenarios with one, two, and three missing images, achieving similar or better results to the state-of-the-art when more images are available. We also evaluate the impact of the proposed changes to the base architecture.

Resumo:

Neste trabalho nós investigamos o enquadramento do problema de geração de personagens em diferentes poses como de imputação de dados ausentes (um problema da área de estatística). Quando falta apenas uma imagem de um personagem, podemos usar todas as que já foram desenhadas como entrada para o modelo gerar o personagem na pose que está faltando. Propomos uma arquitetura que recebe todas as imagens disponíveis e um indicador de qual está faltando e, com isso, consegue gerar o personagem nessa pose. Comparando com baselines baseadas na arquitetura Pix2Pix e StarGAN, nossa arquitetura obteve os melhores resultados tanto em análise qualitativa quanto quantitativa.