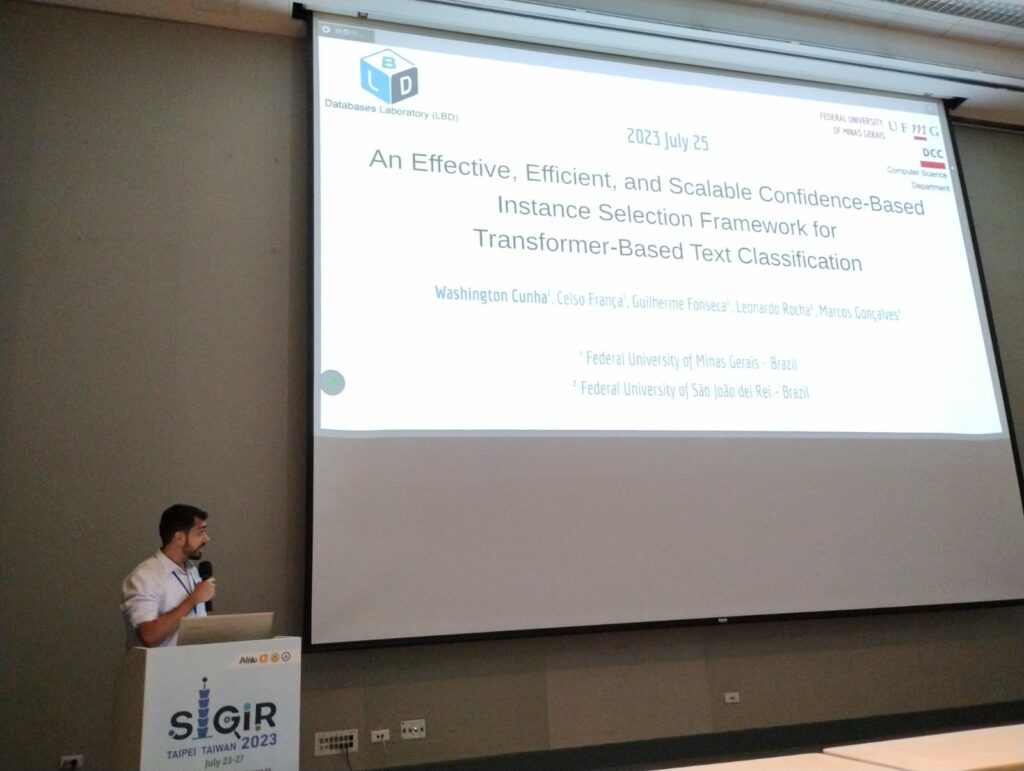

Na última semana de julho, Washington Cunha, aluno do doutorado Programa de Pós-graduação em Ciência da Computação da UFMG, apresentou, durante a 46ª Conferência Internacional ACM SIGIR sobre Pesquisa e Desenvolvimento em Recuperação de Informações, ocorrida Taipei, Taiwan, o artigo intitulado “An Effective, Efficient, and Scalable Confidence-Based Instance Selection Framework for Transformer-Based Text Classification”. O trabalho, que conta com a contribuição do aluno de doutorado Celso França e do professor do Departamento de Ciência da Computação (DCC) Marcos André Gonçalves, trouxe à tona uma abordagem inovadora no campo do Processamento de Linguagem Natural (PLN) e Recuperação de Informação (IR). “O trabalho apresenta uma nova abordagem capaz de identificar os documentos mais representativos para o treinamento de modelos de aprendizado profundos aplicados à tarefa de classificação automática de texto”, explicou Cunha.

Segundo os autores, embora o aprendizado profundo baseado em Transformers seja reconhecido como o estado da arte em diversas tarefas de PLN e IR, ajustar esses modelos para tarefas específicas, como a Classificação de Texto e o Reconhecimento de Entidades, em cenários de crescimento contínuo de dados e limitações de recursos computacionais e financeiros, representa um desafio significativo. “Visando superar essas barreiras, nosso artigo concentrou-se na Seleção de Instâncias (SI) – um conjunto de métodos focados em identificar os documentos mais representativos para o treinamento dos modelos. Essa abordagem visa preservar ou mesmo aprimorar a eficácia dos modelos ao mesmo tempo em que reduz o tempo total de treinamento”, falou Washington.

De acordo com Cunha, o framework proposto, denominado E2SC-IS, apresenta uma abordagem de duas etapas especialmente adaptadas para Transformers e grandes conjuntos de dados. “O E2SC-IS estima a probabilidade de cada instância ser removida do conjunto de treinamento por meio de classificadores fracos, mas escaláveis, rápidos e calibrados. Além disso, o framework emprega uma heurística iterativa para estimar uma taxa de redução quase ótima. Os resultados obtidos foram surpreendentes, com uma média de 29% de redução nos conjuntos de treinamento, mantendo a eficácia em todos os conjuntos de dados, e alcançando ganhos de aceleração de até 70%. Esses números impressionantes foram alcançados mesmo quando lidando com conjuntos de dados extremamente grandes, algo que nunca havia sido alcançado pelas abordagens anteriores”, relatou.

Extremamente feliz com os resultados obtidos no trabalho e pela publicação, Washington se diz mudado com a experiência de participar de uma conferência de tamanha relevância. “Tive um trabalho publicado na maior conferência da minha área. Isso é resultado do grande esforço, dedicação e amor pelo que faço. Ser pesquisador no Brasil não é uma das tarefas mais simples, e enfrentei inúmeras barreiras nos últimos anos para seguir em busca do meu sonho. Mas é importante lembrar que nenhuma pesquisa é feita sozinha, e por trás desses bons resultados, existe uma equipe preparada e disposta a contribuir com o trabalho uns dos outros. Gostaria, portanto, de expressar meus sinceros agradecimentos aos meus orientadores, o professor Marcos André, do DCC/UFMG, e o professor Leonardo Chaves Dutra Rocha, da Universidade Federal de São João del-Re (UFSJ), ao Laboratório de Bancos de Dados, aos colegas que trabalharam comigo nesse artigo, ao DCOMP da UFSJ por me ajudar a descobrir minhas potencialidades, e ao DCC por me auxiliar a explorá-las”, disse.

Ainda segundo o aluno, a contribuição desse estudo para o avanço da pesquisa e inovação na área de PLN e IR é indiscutível. “Esse trabalho de excelência também reafirma a importância de investimentos na pesquisa científica no Brasil. Com profissionais comprometidos, podemos continuar a fazer contribuições significativas para o avanço do conhecimento e o desenvolvimento do país”, concluiu.